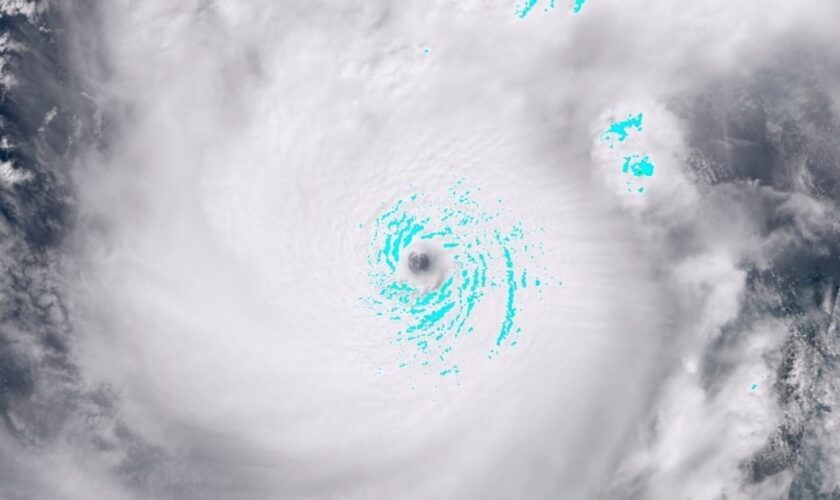

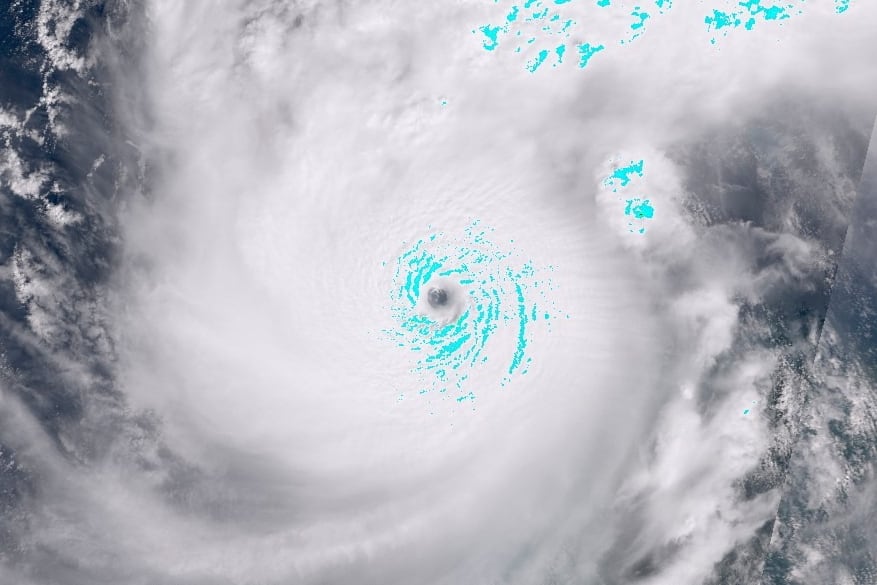

C’est ce qu’on appelle voler la vedette. A la surprise générale, le Nobel de physique a récompensé cette année Geoffrey Hinton et John Hopfield. Deux grands noms de l’intelligence artificielle (IA) et plus particulièrement des réseaux de neurones, massivement utilisés dans la science moderne. Un choix quelque peu controversé parmi les chercheurs du cru, mais qui montre une tendance de fond : l’IA s’immisce partout, y compris dans des domaines où la physique brille depuis des siècles, à l’image de la prévision météorologique.Les dernières percées dans le domaine sont à mettre au compte de grands groupes à l’avant-garde de cette technologie comme Google DeepMind, Nvidia, IBM ou bien Huawei. Le premier cité vient de publier début décembre son nouveau modèle d’intelligence artificielle spécialisé, “GenCast”, entraîné à l’aide des quatre dernières décennies (jusqu’en 2018) de données météo. Présenté dans la revue Nature, “GenCast” réalise des prévisions statistiques sur une multitude de variables jusqu’à 15 jours, sur une résolution spatiale de 31 kilomètres, en se montrant dans 97 % des cas plus précis que les meilleurs modèles traditionnels. Cet été, Google DeepMind avait déjà publié un modèle (“GraphCast”) anticipant la trajectoire de l’ouragan tropical Beryl vers le Texas, alors que les prévisions le voyaient plutôt s’abattre de plein fouet sur le Mexique. Près de quarante personnes sont finalement mortes, dans l’Etat du sud des Etats-Unis. Aucune, au Mexique.Cette précision peut sauver des vies. Elle a aussi des intérêts économiques évidents. En cas de catastrophe, d’abord. “Réduire l’erreur de trajectoire d’un typhon d’un kilomètre en 24 heures peut réduire d’environ 97 millions de yuans (13,54 millions de dollars) les pertes économiques directes […] une prévision précise est essentielle pour minimiser les risques”, écrivait en janvier dernier le média chinois Global Times, à propos d’un modèle d’IA développé localement, aidant à anticiper ces évènements dévastateurs. Plus largement, les entreprises dans l’agriculture, l’industrie, le tourisme, ou les administrations aspirent à toujours plus d’exactitude pour prendre les bonnes décisions. “Le vent sera-t-il assez fort demain pour s’appuyer sur l’énergie renouvelable produite par les parcs éoliens ? Quelle est la probabilité que la température descende en dessous de zéro ?”, interroge par exemple sur son fil LinkedIn Remi Lam, un des scientifiques à l’origine de “GenCast”.Première révolutionPrometteur, d’autant plus que l’histoire d’amour entre l’IA et la météo n’en est qu’à ses débuts. Pierre Gentine, chercheur français spécialisé dans les questions environnementales et professeur à l’université Colombia de New York, situe ses prémices autour de 2018. A l’époque, le monde scientifique célèbre tout juste la première “révolution” de la météo. Les progrès de la puissance de calcul – avec les superordinateurs – permettent d’ingérer les millions de données atmosphériques utiles aujourd’hui disponibles. Il est donc possible de modéliser des prévisions – toujours basées sur des simulations physiques – plus vite et plus précisément que jamais. Le Met Office, au Royaume-Uni, affirme que ses prévisions à quatre jours sont désormais aussi fiables que ses prévisions à un jour l’étaient il y a 30 ans. Le journaliste Andrew Blum compare, dans le livre The Weather Machine : A Journey Inside the Forecast, publié en 2019, le système météo actuel à une “merveille traitée avec banalité”. Un miracle quotidien.Personne ne songe à changer d’approche. Sauf Pierre Gentine, et une poignée d’autres, qui se tournent vers les dernières approches d’intelligence artificielle, les progrès de l’apprentissage automatique (machine learning) et des réseaux de neurones qui excellent à créer des phrases ou des images inédites à partir de l’existant. Anticiper la suite en somme. Au départ, les débuts sont difficiles : les jeux de données ne sont pas optimaux. “La majeure partie de la communauté scientifique était franchement sceptique par rapport à l’intérêt de l’IA, les implémentations des modèles statistiques étaient encore relativement naïves et loin d’égaler les performances des modèles météorologiques existants, relate le chercheur en géosciences Alban Farchi, dans un entretien publié sur le site de l’école des Ponts et Chaussées, en janvier 2024. Mais ces premières initiatives de machine learning n’étaient pas menées par des spécialistes de la prévision et, par la suite, les compagnies internationales ont débauché des météorologues pour les aider à concevoir des architectures efficaces et adaptées.”Le rythme des avancées s’est, dès lors, accéléré. “En quatre ans, on est passé de prédictions médiocres, à égaler avec l’IA ce qui se faisait de mieux”, reprend Pierre Gentine. En 2022, Nvidia, le roi des puces IA (les “GPU”), publie le modèle FourCastNet, se comparant aux prévisions météo numériques à la pointe du Centre européen pour les prévisions météorologiques à moyen terme (CEPMMT). Aujourd’hui, les avancées de Google suggèrent que l’IA peut repousser le mur auquel tous se heurtent : la prévision à plus de 10 jours. “Ce moment où le système devient chaotique”, indique Pierre Gentine. Le risque lié à l’effet papillon : une infime modification des conditions quelque part dans le monde qui chamboule les résultats et les rend caduques. Plus pour longtemps ?Rapide mais insondableC’est l’un des grands espoirs de l’IA. Mais pas le seul. Le “GenCast” de Google produit ses résultats avec une unique puce de type “TPU” en seulement huit minutes. Alors que le CEPMMT mobilise à chaque fois son supercalculateur, soit des dizaines de milliers de processeurs, pendant plusieurs heures. Si l’entraînement des modèles météo basés sur l’IA demande d’importantes ressources, leur utilisation, via un simple ordinateur de bureau, est bien moins coûteuse. Un atout auquel devraient être sensibles des pays pauvres, moins équipés en infrastructures. Chez certains, souligne le site de statistiques de référence Our World in Data, la qualité d’une prévision météo à un jour égale à peine celle à sept jours, plus incertaine, des pays riches. Cela permettrait également d’optimiser les excellentes prévisions journalières des Etats mieux lotis en la matière. “Au lieu de 20 simulations, on peut en réaliser 20 000 et identifier plus facilement où se situe la masse de résultats cohérents”, indique Nicolas Baldeck, fondateur du site Météo-Parapente, et expert en données météo.Des limites demeurent toutefois. Le chercheur français Pierre Gentine est associé à une start-up, Tellus AI, qui essaye d’anticiper les risques à moyen terme, jusqu à plusieurs mois, comme les sécheresses, les vagues de chaleur ou encore les inondations. Un business en vogue, en ce moment, comme l’avait pointé une récente enquête de L’Express. Avec pour objectif la prédiction à plusieurs années, afin d’anticiper des évènements survenant une fois par siècle, comme à Valence, récemment. L’IA ne pourra cependant à elle seule résoudre ce casse-tête. “Ce genre d’inondation arrive une fois tous les 100 ans, il n’y a pas donc pas d’historique dans les données”, confie Pierre Gentine. Les simulations physiques demeurent nécessaires. D’autant que le nombre ou l’intensité des évènements extrêmes pourrait à l’avenir être décuplé par le réchauffement climatique.C’est ce qui explique l’approche encore prudente des institutions phares du milieu. “L’IA reste une boîte noire. On ne peut pas se permettre de fournir une information qui est calculée par un algorithme dont on ne comprend pas le fonctionnement, rappelle à L’Express Laure Raynaud, la “Madame IA” de Météo-France. On recherche plutôt une complémentarité avec la méthode traditionnelle.” Elle l’admet toutefois : Météo-France a été bousculé. “Nous n’avions pas forcément les processeurs GPU à disposition, les compétences en sciences de la donnée. Cela demande de redéfinir certaines priorités et objectifs.” De réorienter ses recherches, continuellement : les mastodontes de la tech sortent de nouveaux modèles plusieurs fois par an. Forçant à une nouvelle forme de collaboration.”Ce n’est pas Google qui décide”Les météorologues contribuent à améliorer les modèles d’IA. Les multinationales tech, elles, partagent leurs codes sources à ces chercheurs, qui les utilisent de plus en plus dans leur quotidien. Tout le monde peut y gagner. Les objectifs entre les organisations et ces multinationales ne sont, de toute façon, pas les mêmes. “Notre priorité est la sécurité des biens et des personnes, indique Laure Raynaud. Ce n’est pas Google qui va décider du passage d’un département français en vigilance orange.” La meilleure prévision n’est pas seulement la plus précise, mais aussi celle qui est correctement acheminée aux habitants d’un espace précis, dans le délai adéquat. Un Météo-France ou le Met Office au Royaume-Uni gardent la confiance du public à ce niveau.La Big Tech est, du reste, dépendante du système traditionnel. “Nous fournissons la matière première”, commente auprès de L’Express Florence Rabier, la météorologue française à la tête du Centre européen pour les prévisions météorologiques à moyen terme (CEPMMT). La spécialiste fait référence aux observations satellites, avions, radio-sondages qui mesurent depuis des décennies la composition de l’atmosphère, et qui sont financés par les organisations gouvernementales et intergouvernementales. Ces infrastructures continuent de se multiplier. Florence Rabier donne pour exemple les constellations de satellites de troisième génération qui entreront bientôt en service en Europe, ouvrant la possibilité de réaliser des prévisions avec une résolution d’un kilomètre seulement. Le succès de la prévision météo repose là-dessus : une collaboration mondiale en temps réel, avec des règles et des normes définies par l’Organisation météorologique mondiale (OMM). Car, tel le nuage de Tchernobyl, la pluie ou le vent ne s’arrête pas aux frontières. “GenCast” de Google n’aurait ainsi pas vu le jour sans le précieux jeu de données “ERA5” du CEPMMT, avec des informations remontant pour certaines jusqu’à 1940.Cela pourrait-il changer ? Un ciel de traîne s’installe au-dessus des prévisionnistes. “La météorologie est depuis longtemps un bien public, mais ces jours sont peut être comptés”, écrivait il y a un an le journaliste et auteur de Weather Machine Andrew Blum, dans le Financial Times. “Ces dernières années ont vu un boom de l’observation privée – microsatellites, ballons et l’adaptation des métadonnées des téléphones portables à la détection météorologique. Ce que cela laisse présager, c’est une dégradation de l’ordre international de la météo qui a tenu depuis la Seconde Guerre mondiale”, alerte-t-il. La Big Tech aura peut-être un jour les moyens de façonner ses propres jeux de données. “Ce n’est pas pour tout de suite”, rassure Florence Rabier, du CEPMMT. Tout en restant prudente, consciente de l’ascension extraordinaire de ces entreprises dans de très nombreux domaines au-delà de la météo. “Il faudra continuer à faire du mieux possible, afin de ne pas reposer sur des grands groupes technologiques.” Ces dix dernières années, l’ouverture massive des données a également contribué à la naissance de myriade de pastilles météo sur nos smartphones. Celles gratuites et pré-installées d’Apple ou de Google qui nous livrent la probabilité qu’il pleuve dans l’heure, avant le début d’un footing. Mais aussi les “Windy”, “RainToday” ou “Météociel”, si populaires sur les magasins d’application, qu’elles volent aujourd’hui la vedette à Météo-France. Un peu comme les chercheurs d’IA aux physiciens.

Source link : https://www.lexpress.fr/economie/high-tech/comment-lintelligence-artificielle-revolutionne-la-prevision-meteo-traditionnelle-ZDIU6WW3EJGOZGI4KVW3GSGGT4/

Author : Maxime Recoquillé

Publish date : 2024-12-15 07:00:00

Copyright for syndicated content belongs to the linked Source.